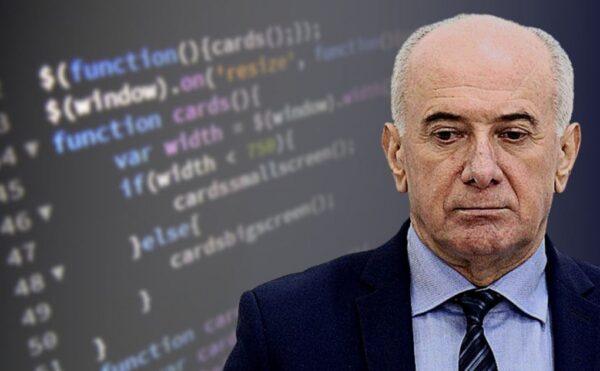

Kakav će umjetna inteligencija imati utjecaj na naše živote, hoće li prevladati pozitivne ili negativne strane AI te treba li regulirati ove tehnologiju, samo su neke od tema o kojima je govorio Sam Altman pred američkim senatskim odborom. Iako je svima koji su prate tehnološku industriju Altman dobro poznat, šira javnost upoznala ga je nakon predstavljanja ChatGPT-a. Naime, upravo je on CEO OpenAI-a, kompanije koja je razvila taj chatbot, prenosi zimo.hr.

U razgovoru s članovima odbora Altman je pozvao na regulaciju ovog tržišta te je upozorio na potencijalne opasnosti. O regulaciji umjetne inteligencije govori se sve više, a kao prijedlog Altman je spomenuo pokretanje nove agencije u SAD-u koja bi bila zadužena za donošenje pravila i zakona, a koja bi, među inim, izdavala i oduzimala dozvole AI kompanijama.

U razgovoru s članovima senatskog odbora naglasio je kako umjetna inteligencija ima nevjerojatan i revolucionaran potencijal, no upozorio je i na potencijalne opasnosti. Utjecat će na poslove. Pokušavamo biti jako jasni oko toga, potvrdio je kako će ovaj oblik tehnološkog napretka donijeti i otpuštanja te će AI na nekim pozicijama zamijeniti ljude. Također, Altman je izrazio svoju zabrinutost oko potencijalnog utjecaja umjetne inteligencije na demokraciju jer bi se AI mogla iskoristiti za širenje lažnih vijesti tijekom izbora.

Senatori su, čini se, također svjesni pozitivnog i negativnog potencijala AI. Tako je Josh Hawley rekao kako bi AI mogla biti revolucionarna, no uspredio ju je s atomskom bombom, dok je senator Richard Blumenthal naglasio kako budućnost u kojoj dominira AI “nije nužno budućnost koju želimo”. Ono što je potrebno, smatra Blumenthal, jest maksimizirati dobre stvari u odnosu na loše: Kongres sada ima izbor. Imali smo isti izbor s društvenim mrežama. U tome nismo uspjeli.

Zaključak saslušanja jest da postoji politička volja za novim regulatornim tijelom, no uz tehnologiju koja se tako brzo razvija postavlja se pitanje može li takvo tijelo držati korak s brzim promjenama tehnološke industrije.